4月25日,技术媒体Marktechpost昨天(4月24日)发布了一篇博客文章,报告

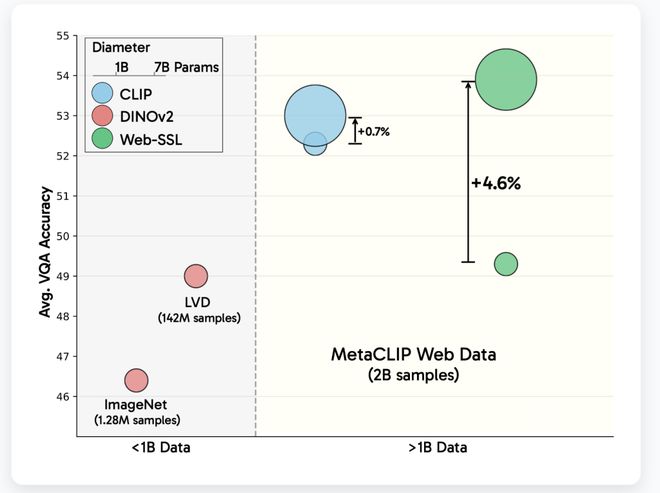

4月25日的新闻,技术媒体MarkechPost昨天(4月24日)发表了一篇博客文章,报道说,Meta模型以3亿至70亿的参数量表发布了WebSL系列。它基于对图像数据的纯粹培训,旨在探索无需语言管理的视觉研究监督研究(SSL)的潜力。代表OpenAI剪辑,对比图像模型成为研究视觉表示形式的默认选项,并且是视觉问题和答案(VQA)和文档理解等多模式活动所独有的。但是,由于数据集和数据大小的复杂性,语言依赖方面遇到了许多挑战。为了响应上述疼痛点,Meta在Embrace Face平台上发布了一系列WebL模型,涵盖Dino和Vision Transfo Architecturer(VIT),参数尺度从3亿至70亿。这些模型仅在MetaClip数据集(MC-2B)上仅使用20亿张图像进行训练,不包括TH语言管理的影响。 Meta的目标不是替换剪辑,而是要检查执行纯视觉监督研究(SSL)的潜力,而没有数据限制和模型大小通过可变控件。 WebL模型采用了两次视觉监督研究游行:联合嵌入学习(DINOV2)和面具建模(MAE)。平等训练使用224×224分辨率图像并冻结视觉编码器,以确保结果的差异仅带有预训练方法。该模型以五个级别的容量(VIT-1B至VIT-7B)进行了训练,并根据Cambrian-1基准进行了审查,涵盖了16VQA活动,包括一般的视觉理解,知识推理,OCR和图形解释。此外,该模型与拥抱面孔的变形金刚库无缝集成,以易于研究和应用。实验显示了一些基本发现:随着参数大小的增加,VQA活动中的WebL模型性能接近Developme线性对数的NT,而夹子性能往往会在超过30亿个参数后浸泡。 WebL在OCR和图表活动中尤其众所周知,尤其是在数据筛选之后,该剪辑超过了剪辑,只有1.3%的文本图像培训,并且在OCRbench和ChartQA活动中最多可提高13.6%。此外,高分辨率(518px)微调将使用高分辨率模型(例如香烟)缩小差距,主要在文档任务中执行。 WebSL模型仍然显示出与假装语言模型(例如Llama-3)无语言管理的一致性,这表明大型视觉模型可以明确了解与文本语义相关的功能。同时,网络处于传统的基准测试(因为IMA的基因1K分类,ADE20K段中的性能很强),并且某些情况比MetaClip和Dinov2更好。 【来源:这在家】

4月25日的新闻,技术媒体MarkechPost昨天(4月24日)发表了一篇博客文章,报道说,Meta模型以3亿至70亿的参数量表发布了WebSL系列。它基于对图像数据的纯粹培训,旨在探索无需语言管理的视觉研究监督研究(SSL)的潜力。代表OpenAI剪辑,对比图像模型成为研究视觉表示形式的默认选项,并且是视觉问题和答案(VQA)和文档理解等多模式活动所独有的。但是,由于数据集和数据大小的复杂性,语言依赖方面遇到了许多挑战。为了响应上述疼痛点,Meta在Embrace Face平台上发布了一系列WebL模型,涵盖Dino和Vision Transfo Architecturer(VIT),参数尺度从3亿至70亿。这些模型仅在MetaClip数据集(MC-2B)上仅使用20亿张图像进行训练,不包括TH语言管理的影响。 Meta的目标不是替换剪辑,而是要检查执行纯视觉监督研究(SSL)的潜力,而没有数据限制和模型大小通过可变控件。 WebL模型采用了两次视觉监督研究游行:联合嵌入学习(DINOV2)和面具建模(MAE)。平等训练使用224×224分辨率图像并冻结视觉编码器,以确保结果的差异仅带有预训练方法。该模型以五个级别的容量(VIT-1B至VIT-7B)进行了训练,并根据Cambrian-1基准进行了审查,涵盖了16VQA活动,包括一般的视觉理解,知识推理,OCR和图形解释。此外,该模型与拥抱面孔的变形金刚库无缝集成,以易于研究和应用。实验显示了一些基本发现:随着参数大小的增加,VQA活动中的WebL模型性能接近Developme线性对数的NT,而夹子性能往往会在超过30亿个参数后浸泡。 WebL在OCR和图表活动中尤其众所周知,尤其是在数据筛选之后,该剪辑超过了剪辑,只有1.3%的文本图像培训,并且在OCRbench和ChartQA活动中最多可提高13.6%。此外,高分辨率(518px)微调将使用高分辨率模型(例如香烟)缩小差距,主要在文档任务中执行。 WebSL模型仍然显示出与假装语言模型(例如Llama-3)无语言管理的一致性,这表明大型视觉模型可以明确了解与文本语义相关的功能。同时,网络处于传统的基准测试(因为IMA的基因1K分类,ADE20K段中的性能很强),并且某些情况比MetaClip和Dinov2更好。 【来源:这在家】